· Andreas Schwarz · Fachartikel · 7 min read

Altlasten Adé: Legacy-Systeme clever automatisieren

Prozessautomatisierung baut Brücken zwischen Legacy-Systemen und moderner IT. Der Artikel zeigt einen pragmatischen Weg von Pilot bis Skalierung mit Governance, Risiken und Kennzahlen.

Teaser

Legacy-Systeme laufen stabil, kosten aber viel und blockieren neue Ideen. Dieser Artikel zeigt, wie Sie Alt und Neu verbinden, ohne das Tagesgeschäft zu gefährden. Sie erhalten klare Kriterien zur Auswahl passender Prozesse, eine realistische Roadmap vom Pilot bis zum Betrieb sowie Maßnahmen für Sicherheit, Governance und Monitoring. Dazu thematisieren wir Aufwand und Nutzen, Hinweise auf Risiken und eine Einordnung, wo Künstliche Intelligenz heute wirklich hilft. Ziel ist ein tragfähiger, pragmatischer Ansatz, der schnell Wirkung zeigt und sich sicher skalieren lässt.

Altlasten Adé: Legacy-Systeme clever automatisieren

Warum Legacy-Systeme bleiben und trotzdem bremsen

Altsysteme sind oft das Rückgrat kritischer Abläufe. Sie wurden bezahlt, sind abgeschrieben und an die Besonderheiten des Unternehmens angepasst. Gleichzeitig erzeugen sie Datensilos, erschweren die Integration und zwingen zu manuellen Arbeiten. Fehlende oder proprietäre Schnittstellen führen zu Medienbruch-Momenten, die Qualität und Geschwindigkeit drücken. Große Teile des IT-Budgets fließen in Betrieb und Wartung, was die Spielräume für Erneuerung schmälert. Der Wunsch, alles zu ersetzen, ist nachvollziehbar; die operative Realität macht ihn jedoch riskant.

Eine Brücke statt Abriss ist deshalb oft der bessere Weg. Prozessautomatisierung verbindet Altsysteme mit neuen Anwendungen, ohne tief in Kernsysteme einzugreifen. Sie schafft Tempo, reduziert Fehler und sorgt für nachvollziehbare Abläufe. Entscheidender Vorteil: Sie kann iterativ eingeführt werden, mit klaren Lernerfahrungen und überschaubarer Exposition. Wer Übergänge sauber gestaltet, gewinnt Zeit, Transparenz und belastbare Entscheidungsgrundlagen für spätere Modernisierungsschritte.

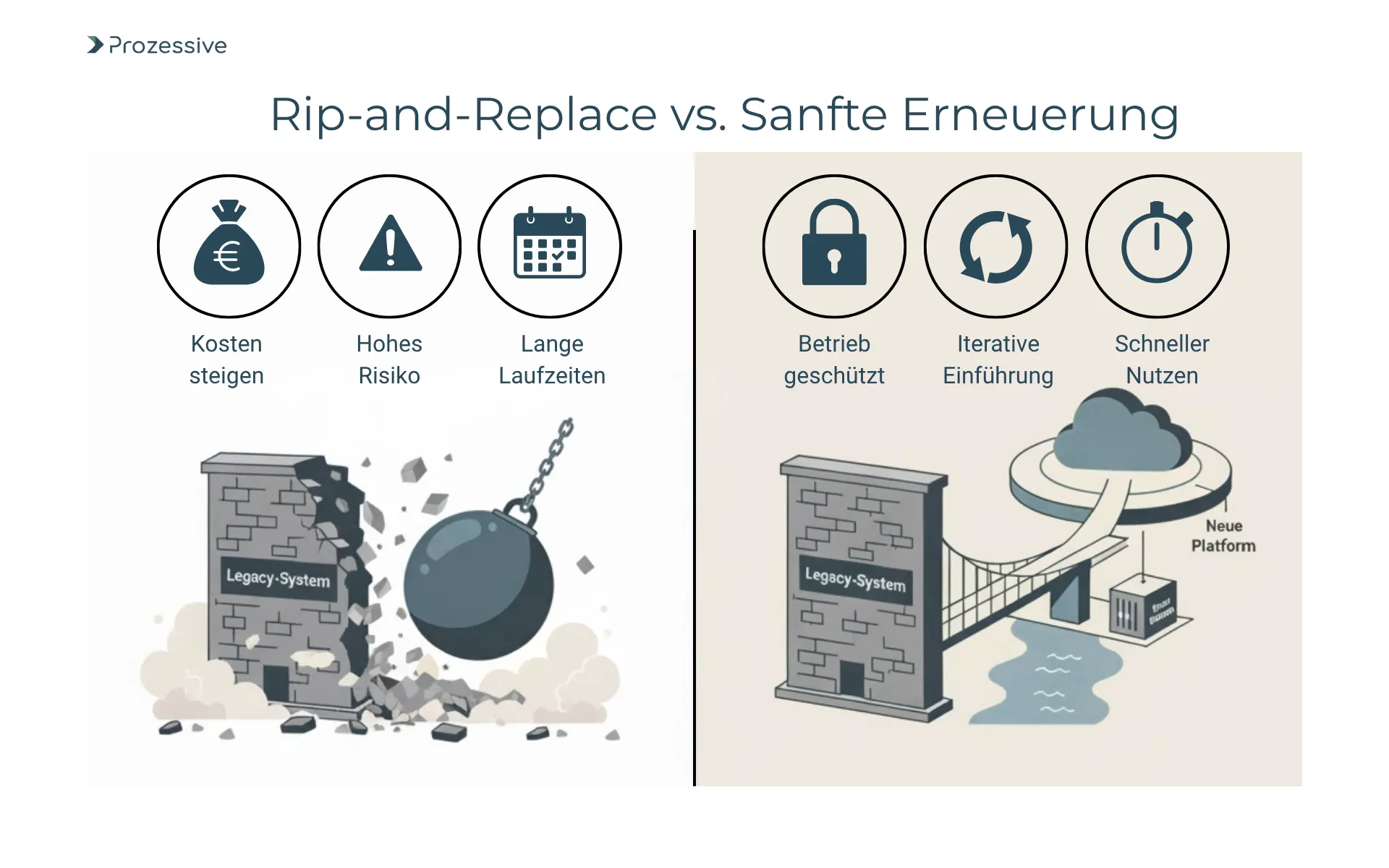

Rip-and-Replace vs. sanfte Erneuerung

Rip-and-Replace klingt sauber: Ein neues System ersetzt das alte, alle Probleme sind gelöst. In der Praxis häufen sich Risiken - Datenmigration, komplexe Abhängigkeiten, Regelwerke und Spezialfälle. Projektlaufzeiten dehnen sich, Kosten steigen, Change-Management kollidiert mit dem Tagesgeschäft. Großprojekte benötigen bis zu 36 Monate und länger, während sich Rahmenbedingungen ändern. Das Ergebnis ist oft eine weitere Verschiebung, während Arbeit und Fehler im Bestand weiterlaufen. Die Folge: Strategische Müdigkeit und allgemeine Verunsicherung in den Teams.

Die sanfte Erneuerung koppelt Ertrag und Risiko. Sie automatisiert zuerst Schnittstellen und Abläufe, die heute bremsen, und schützt so den operativen Betrieb. Medienbrüche werden systematisch reduziert, während Kernmodelle unberührt bleiben.

Wer Brücken baut, gewinnt Zeitfenster für fundierte Architekturentscheidungen.

Erst wenn Prozesse stabil laufen, werden Funktionen schrittweise modernisiert oder migriert. So bleiben Kosten steuerbar und Lerneffekte fließen in die nächste Ausbaustufe. Rip-and-Replace behält seinen Platz dort, wo Systeme strukturell am Ende sind oder regulatorische Vorgaben es erzwingen.

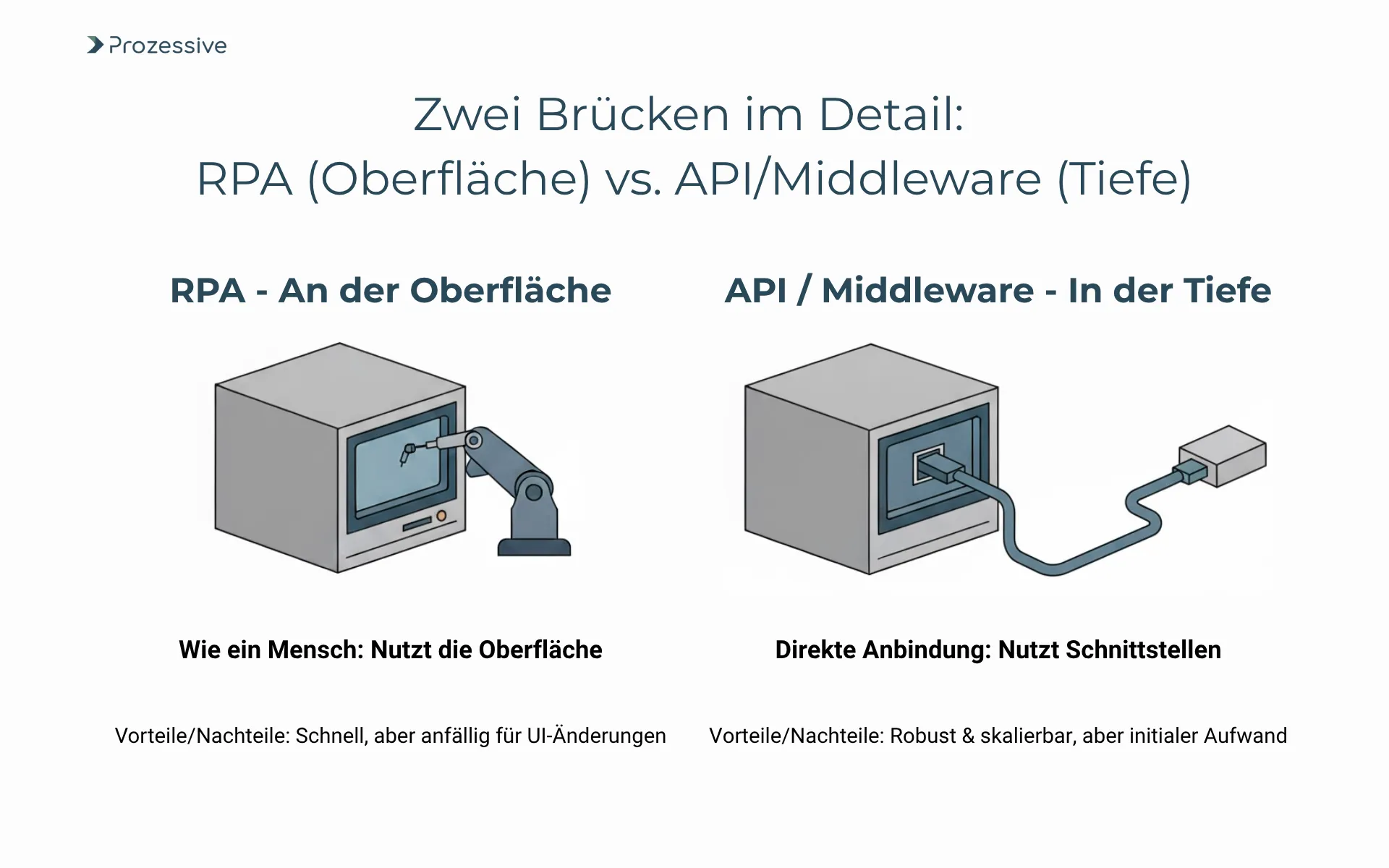

Zwei Brücken im Detail: RPA an der Oberfläche, APIs und Middleware in der Tiefe

Robotic Process Automation (RPA) arbeitet an der Oberfläche. Bots lesen und schreiben Daten über die Benutzeroberfläche, so wie Mitarbeitende es tun. Sie erkennen Felder, navigieren Menüs und verarbeiten Dateien. Vorteil: Kein Eingriff in das Legacy-System, schnelle Ergebnisse, gute Überbrückung bei fehlenden Schnittstellen. Grenzen: Layout-Änderungen, eingeschränkte Geschwindigkeit, potenziell höhere Wartungskosten. Für stabile, wiederkehrende Aufgaben ist Robotic Process Automation ein präzises Werkzeug.

APIs und Middleware arbeiten in der Tiefe. Sie nutzen vorhandene Datenbanken, CSV-Exports, proprietäre Gateways oder ereignisbasierte Tätigkeiten. Eine Integrationsschicht kapselt Geschäftslogik, steuert Zugriffe, protokolliert und setzt Policy-Regeln durch. Vorteil: Saubere Prozessintegration, höhere Skalierbarkeit, bessere Sicherheit und Wiederverwendbarkeit. Grenzen: Initialer Aufwand, notwendige Expertise, potenzieller Eingriff in Systeme oder Infrastruktur. In Kombination spielen beide Stärken aus: RPA für schnelle Brücken, APIs und Middleware für tragfähige Schnittstellen.

Robustheit entsteht durch ergänzende Muster: Idempotente Operationen, Wiederholungen bei Fehlern, Backup-Strategien, zentralisierte Passwort-Verwaltung und Logging. Ein Orchestrator steuert Prioritäten, Last und Abhängigkeiten. Damit lassen sich Ende-zu-Ende-Automatisierungen resilient gestalten, auch wenn einzelne Komponenten schwanken. So wird die Brücke nicht nur schnell gebaut, sondern dauerhaft belastbar.

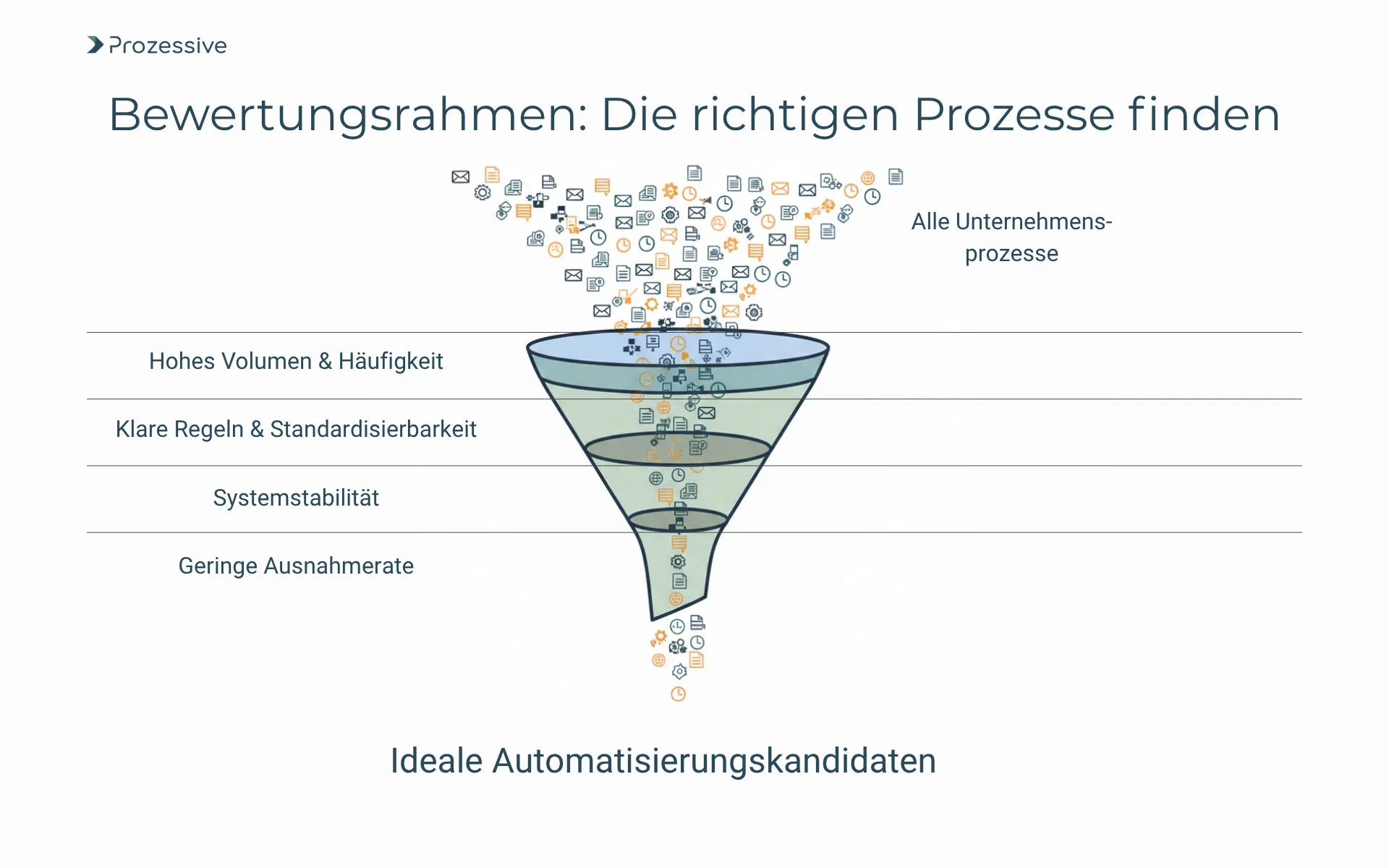

Bewertungsrahmen für Kandidatenprozesse

Analog zur Prozesssuche bei anderen Automatisierungsstrategien gestaltet sich die Arbeit bei Alt-Systemen: Die Auswahl passender Prozesse entscheidet über Tempo und Wirkung. Geeignet sind Fälle mit hohem Volumen, klaren Regeln und stabilen Oberflächen. Compliance-Vorgaben und Sicherheitsanforderungen müssen früh berücksichtigt werden, ebenso Datenqualität und Änderungsdynamik. Ziel ist eine transparente Scoring-Logik, die Aufwand, Risiko und Nutzen in Beziehung setzt. Die Priorisierung erfolgt faktenbasiert, nicht nach Lautstärke oder Bauchgefühl. Das erhöht die Trefferquote der ersten Vorhaben und schafft Vertrauen.

- Volumen und Häufigkeit: Viele Vorgänge pro Woche, kurze Bearbeitungszyklen, wiederkehrend ohne saisonale Spitzen

- Regelmäßigkeit und Standardisierbarkeit: Klare Entscheidungsregeln, niedrige Varianz, gut dokumentierte Ausnahmefälle

- Systemstabilität: Seltene UI-Änderungen, stabile Antwortzeiten, planbare Wartungsfenster

- Ausnahmeraten: Geringer Anteil manueller Nacharbeit, klare Eskalationswege bei Abweichungen

- Compliance und Sicherheit: Prüfbarkeit, Vier-Augen-Prinzip, rollenbasierte Zugriffe und Audit-Trails

- Datenqualität: Konsistente Stammdaten, eindeutige Identifikatoren, klare Quellsystem-Ownership

- Änderungsdynamik: Geringe Release-Frequenz, vorausschaubare Änderungen, Zugriff auf Testumgebungen

Ein solcher Bewertungsrahmen macht Annahmen transparent und reduziert Fehleinschätzungen. Wichtig ist, die Kriterien regelmäßig zu schärfen und mit Ergebnissen aus Piloten abzugleichen. So entsteht ein lernendes Portfolio, das mit jedem Schritt präziser wird und bessere Renditen ermöglicht.

Umsetzungsfahrplan: Von der Idee zum skalierbaren Betrieb

Ein realistischer Fahrplan startet fokussiert. Phase 1 definiert Problem, Zielbild und Messgrößen. Phase 2 liefert einen Pilot mit Ende-zu-Ende-Nutzen, oft in 8-12 Wochen. Phase 3 erweitert bestehende Systeme, automatisiert Varianten und härtet Betrieb und Sicherheit. Dabei entsteht ein schlankes Fuindament mit Leitplanken statt Bürokratie. Der Fokus bleibt auf nachweisbarem Mehrwert und wiederverwendbaren Bausteinen.

- Klein starten, groß denken: Ein Ende-zu-Ende-Pilot, klarer Rahmen, saubere Messung, keine Feature-Sammlungen

- Architektur früh definieren: Orchestrierung, Passwörter, Namenskonvention, Logging, Tests, Deployment

- Qualität sichern: Staging-Umgebungen, realistische Testdaten, Regressionstests für Prozessablauf und UI

- Fachbereich einbinden: Verantwortung festlegen, Eskalationsregeln, klare Eingabe- und Ausgabe-Verantwortung

- Messung etablieren: Laufende Kosten pro Prozess sichtbar machen, nutzungsbasiert steuern

- Lernschleifen fixieren: Retrospektiven, Ursachenanalyse, Anpassungen in Standards verankern

- Skalierung planen: Wiederverwendbare Komponenten, Templates, Referenz-Integrationen

KPIs steuern die Entwicklung: Durchlaufzeit, First-Time-Right, Ausnahmerate, STP-Quote und Netto-Nutzen. Für die KPI-Messung sollten Referenzwerte vor dem Pilot erhoben und konsistent weitergeführt werden. So bleibt die Vielfalt der Lösungen kontrollierbar.

Risiken, Nebenwirkungen und Gegenmaßnahmen

Viele Programme scheitern nicht an der Technik, sondern an fehlender Verantwortung. Automatisierungswildwuchs ohne Namenskonventionen, Logging oder Wartungspläne endet in Intransparenz. UI-Automatisierung führt bei größeren Layout-Änderungen zu Ausfällen. Schatten-IT und lokale Admin-Rechte gefährden Compliance. Vendor-Lock-in beschränkt die Gestaltungsfreiheit und verteuert Sourcing. Gegenmittel sind früh definierte Standards, dedizierte Verantwortliche und ein Katalog wiederverwendbarer Bausteine. Wichtig ist ein risikobasierter Ansatz statt pauschaler Verbote.

Stabilität entsteht, wenn Ausnahmewege so gut definiert sind wie der Standardweg und genauso automatisiert überwacht werden.

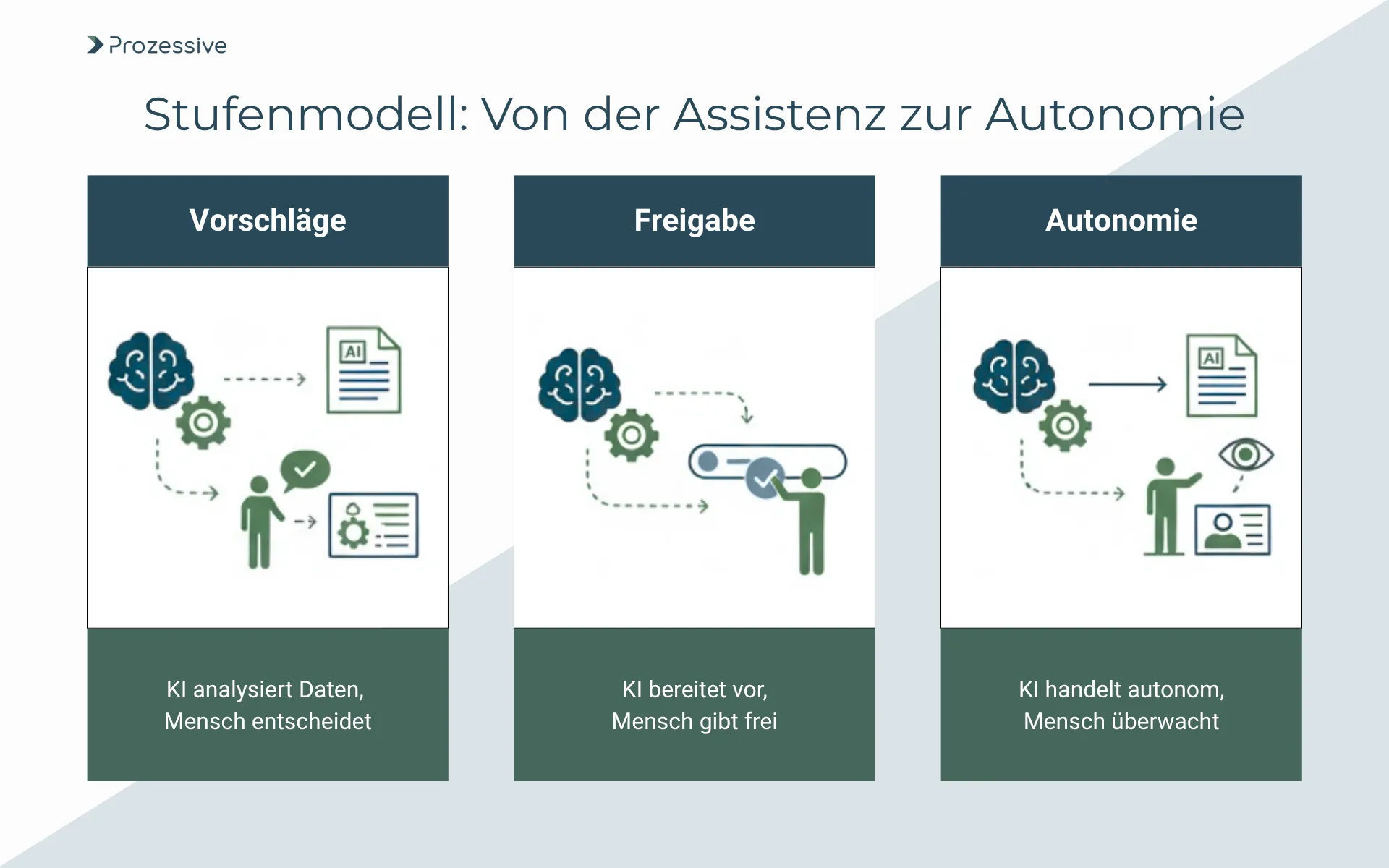

Blick nach vorn: Mehrwert durch Künstliche Intelligenz

Künstliche Intelligenz ergänzt die Brücke, sie ersetzt sie nicht. Heute liefert sie Nutzen bei Dokumenten-Extraktion, Klassifikation, Entitätenerkennung und bei der Erkennung von Ausnahmen. Prognosen für Arbeitslast und Anomalien stabilisieren Durchsatz und Servicegrade. In regulierten Prozessen bleibt Vorsicht angemessen: erklärbare Modelle, reproduzierbare Ergebnisse, saubere Trainingsdaten. Risiken liegen in Verzerrungen, Datenabfluss und schwer nachvollziehbaren Entscheidungen. Ein konservativer Start mit klaren Testkriterien ist sinnvoll.

In Zusammenspiel der Technologien entsteht ein großer Mehrwert : KI extrahiert und strukturiert, RPA und Schnittstellen verarbeiten deterministisch. So lassen sich Prozesse robust automatisieren, auch wenn Eingangsdaten unvollständig sind. Der Übergang zur teilautonomen Steuerung erfolgt schrittweise: Zunächst liefert KI lediglich Vorschläge. Im nächsten Schritt liefert sie Ergebnisse, die vom Mensch freigegeben werden. Im Zielbild erhält sie für die Aufgabe angemessene begrenzte Autonomie. Die Digitalisierung wird damit planbarer, da jeder Schritt messbar bleibt. Wer diese Disziplin hält, vermeidet Übermut und baut eine belastbare Betriebsbasis für spätere Innovationen.

Fazit

Legacy-Systeme sind kein Hindernis, wenn man sie richtig einbindet. Prozessautomatisierung als Brücke schafft schnelle Wirkung, reduziert Fehler und liefert Daten für fundierte Architekturentscheidungen. Der Schlüssel liegt in einem klaren Bewertungsrahmen, einer realistischen Roadmap und starker Governance. Risiken werden benannt und adressiert, statt verdrängt. KI liefert dort Zusatznutzen, wo sie sich belastbar prüfen lässt. Starten Sie pragmatisch mit einem schlanken Pilot, messen Sie konsequent und verstetigen Sie, was funktioniert. So entsteht Schritt für Schritt eine integrierte Landschaft, die Alt und Neu wirksam verbindet.