· Andreas Schwarz · Fachartikel · 7 min read

Routine & Ineffizienz: Ihr teuerster Mitarbeiter

Routineaufgaben und Ineffizienzen kosten Zeit, Geld und Fokus. Dieser Leitfaden zeigt Ursachen, Zahlen und einen pragmatischen Einstieg zur Entlastung.

Teaser

Routineaufgaben binden Kapazität, erzeugen Fehler und verdrängen wichtige Themen. Dieser Beitrag erklärt, warum Routine und Ineffizienz stille Kostentreiber sind und wie Sie mit gezielter Prozessautomatisierung pragmatisch und nachhaltig Abhilfe schaffen. Sie erhalten konkrete Beispiele, belastbare Annahmen und einen handhabbaren Fahrplan. Unser Ziel ist es, ohne große Vorleistung oder unkontrollierbare Risiken, spürbare Entlastung zu schaffen, Margen zu schützen und den Fokus Ihres Teams auf Kunden und Innovation zurückzuführen.

Routine & Ineffizienz: Ihr teuerster Mitarbeiter

Warum Routine und Ineffizienz teuer sind

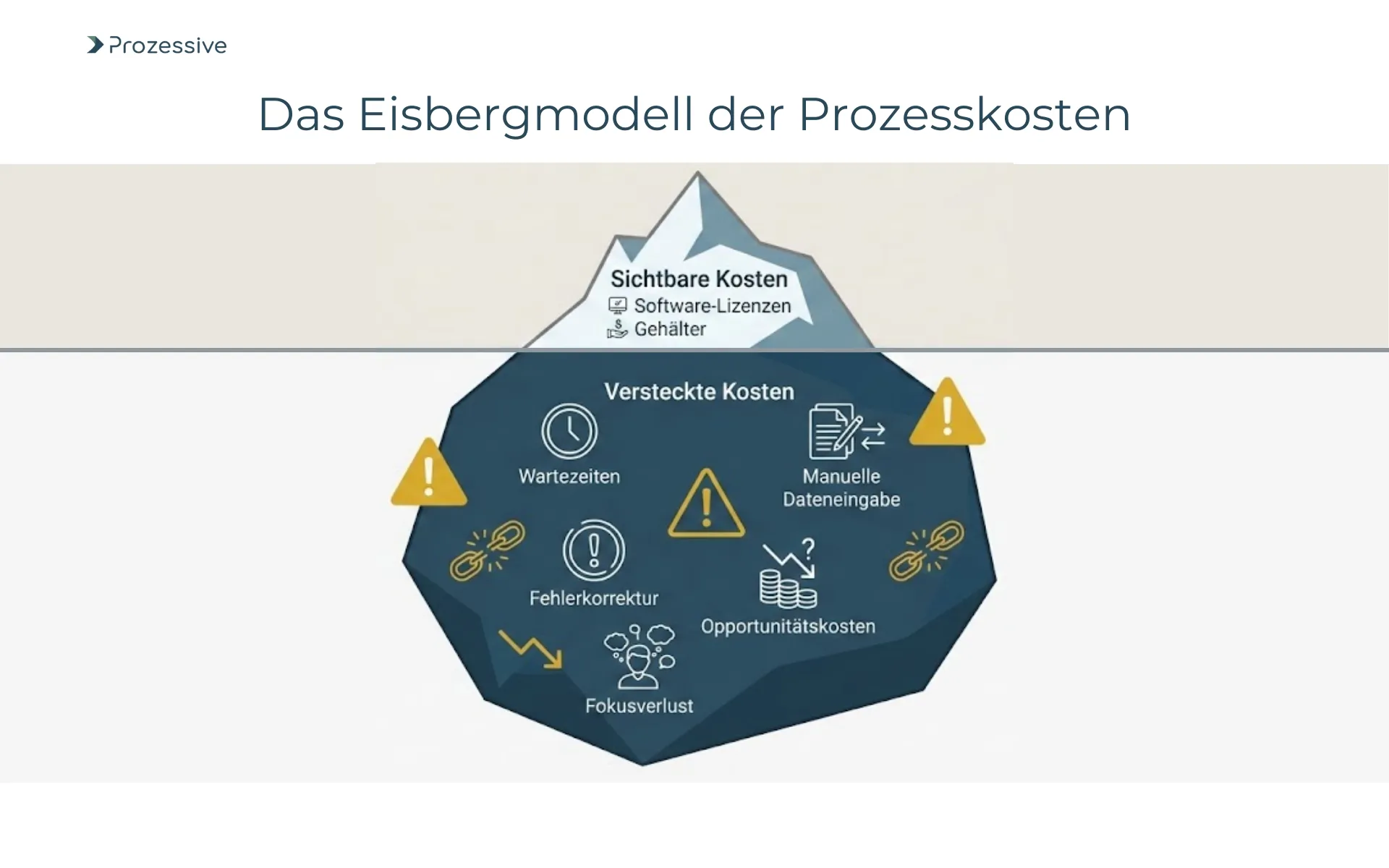

Routine in Geschäftsprozessen meint wiederkehrende, regelbasierte, manuelle Arbeit, oft mit identischen Klickabfolgen und Datentransfers. Ineffizienz entsteht, wenn dabei Zeit vergeudet, Informationen mehrfach erfasst oder Fehler produziert werden. In wachsenden Unternehmen wächst die Komplexität, während Abläufe selten systematisch bereinigt werden. Gebundene Fachkräfte arbeiten sich dann durch Tabellen und Formulare, statt Kundenanliegen zu lösen oder neue Angebote zu testen. Das Ergebnis ist Fokusverlust und eine verdeckte Kostenstruktur, die Budgets aufreibt.

Routine ist kein Zeichen von Stabilität, sondern ein Hinweis auf ungenutztes Potenzial und schleichende Margenverluste.

Zudem verschärfen Medienbrüche und fehlende Transparenz die Lage: Informationen liegen verteilt, Durchlaufzeiten verlängern sich, und Arbeitspakete hängen an einzelnen Personen. Ein konservativer Blick zeigt, dass manuelle Übertragungen typischerweise mit Fehlerquoten im niedrigen einstelligen Prozentbereich einhergehen. Jeder Fehler erzeugt Nacharbeit, Wartezeiten und Unzufriedenheit. Diese Effekte sind kumulativ und treffen genau dort, wo es am meisten schmerzt: bei Margen, Kapazität und Geschwindigkeit.

Praxisnah: typische Situationen

Im Alltag zeigt sich die Belastung durch Routine vor allem dort, wo Daten bewegt, geprüft oder verteilt werden. Der operative Druck führt zu Workarounds, die kurzfristig helfen, aber mittel- und langfristig blockieren. Die folgenden Fälle sind bewusst knapp und praxisnah formuliert. Sie sollen Wiedererkennung ermöglichen und einen Einstieg in die Priorisierung liefern. Die Liste ist beispielhaft und nicht abschließend.

- Tägliche Berichte werden aus drei Systemen exportiert, in Excel zusammengeführt und per E-Mail verteilt.

- Kundendaten werden manuell zwischen CRM, Ticket-System und Buchhaltung übertragen, inklusive Doppelerfassung.

- Bestellungen aus einem Webshop werden per Copy & Paste in ein ERP eingetragen, inklusive Statusabgleich.

- Rechnungsprüfung erfolgt mit PDF-Dokumenten und manuellen Prüf-Checklisten, Rückfragen per E-Mail.

- Stammdatenpflege geschieht sporadisch, weshalb Korrekturen und Nachfragen die Teams ausbremsen.

- Onboarding neuer Mitarbeitender erfordert das händische Anlegen mehrerer Benutzerkonten und Zugriffsrechte.

- Serviceanfragen werden als Freitext erfasst und manuell kategorisiert, bevor sie zugewiesen werden.

Diese Muster haben gemeinsam, dass sie wertvolle Zeit binden und die Fehleranfälligkeit erhöhen. Sie verhindern Skalierung, weil mehr Volumen direkt mehr Aufwand bedeutet. Wenn Teams mit Routine kämpfen, bleibt weniger Energie für Kunden, Angebote und Qualität. Genau hier schafft gezielte Entlastung Freiräume für wertschöpfende Arbeit.

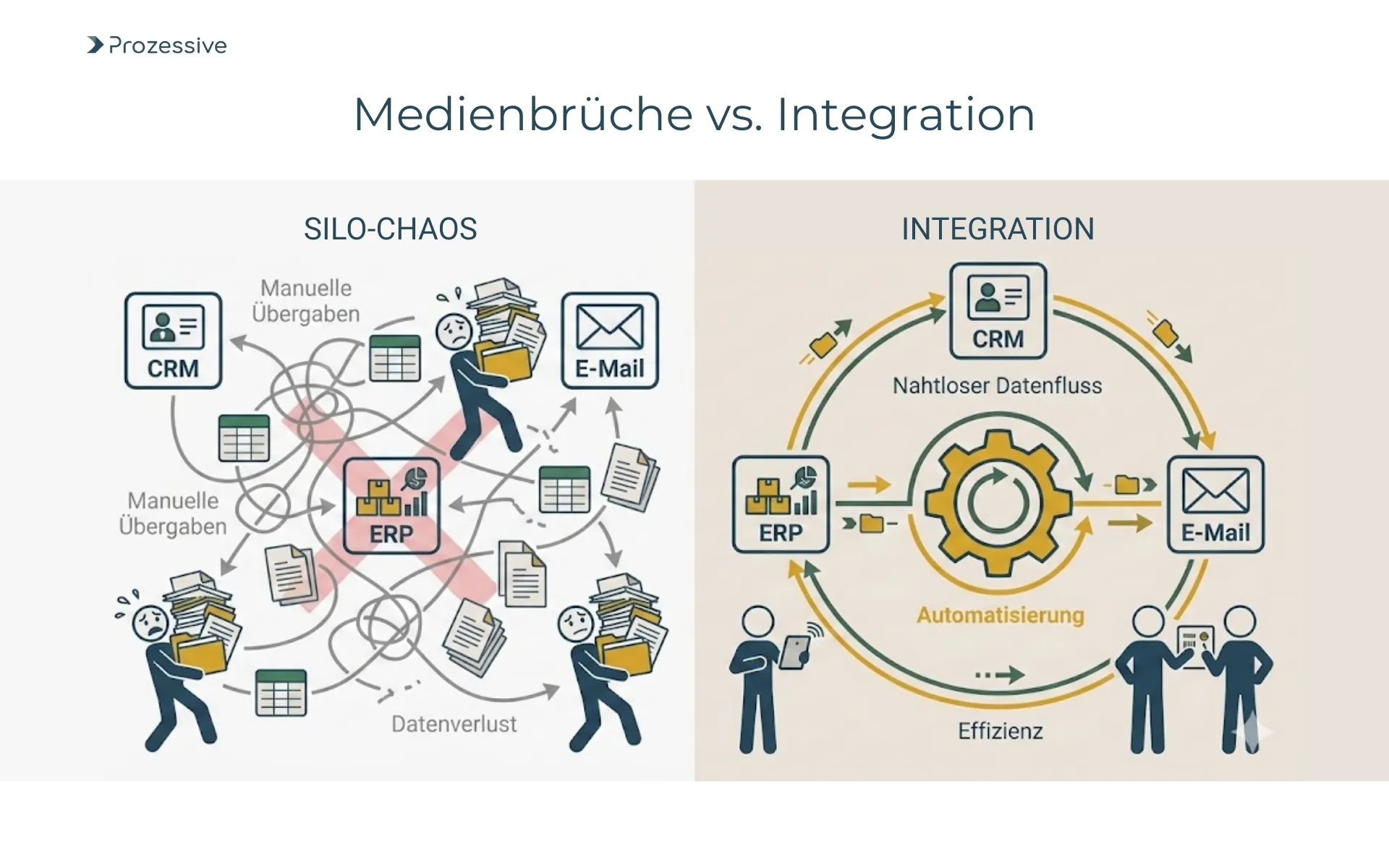

Ursachen im Kern: fehlende Integration statt fehlender Leistung

Viele Teams arbeiten am Limit, obwohl sie leistungsfähig sind. Der Engpass sind selten die Menschen, sondern die Systemlandschaft: historisch gewachsene Tools, fehlende Standards und manuelle Übergaben.

Es entstehen Brüche zwischen Anwendungen, die eigentlich zusammenspielen sollten. Der Alltag wird dann durch Regeln im Kopf und manuelle Kontrollen zusammengehalten. Das ist anfällig, teuer und nicht skalierbar.

Die Wurzel ist oft fehlende Integration mit klaren Datenflüssen, Rollen und Verantwortlichkeiten. Ohne definierte Schnittstellen entsteht jedes Mal ein Einzelfall. Mitarbeitende kompensieren das durch zusätzliche Schritte, was die Durchlaufzeit verlängert. Genau deshalb ist der Hebel nicht mehr Kontrolle, sondern besseres Zusammenspiel der Systeme. Integration senkt Reibung, reduziert Variabilität und macht Qualität vorhersehbar.

Was es kostet: Zeitverluste, Fehler, Margen, Opportunitätskosten

Zeit ist der sichtbarste Faktor. In typischen Office-Rollen entfallen ca. 15 bis 25 Prozent der Arbeitszeit auf manuelle Datenerfassung und -übertragung. Selbst bei nur 10 Prozent wären das bei 100 Vollzeitkräften rund 20.000 Stunden pro Jahr. Diese Zeit fehlt an anderer Stelle, etwa im Vertrieb oder in der Produktpflege. Zusätzlich verlängern sich Durchlaufzeiten, was Wartezeiten und Eskalationen erzeugt.

Fehlerkosten sind der stillere Teil. Konservativ liegt die Fehlerquote bei manueller Übertragung im Bereich von 1 bis 3 Prozent. Je nach Prozess führt jeder Fehler zu 5 bis 30 Minuten Nacharbeit, teils zu Verzögerungen in Auszahlungen oder Lieferungen.

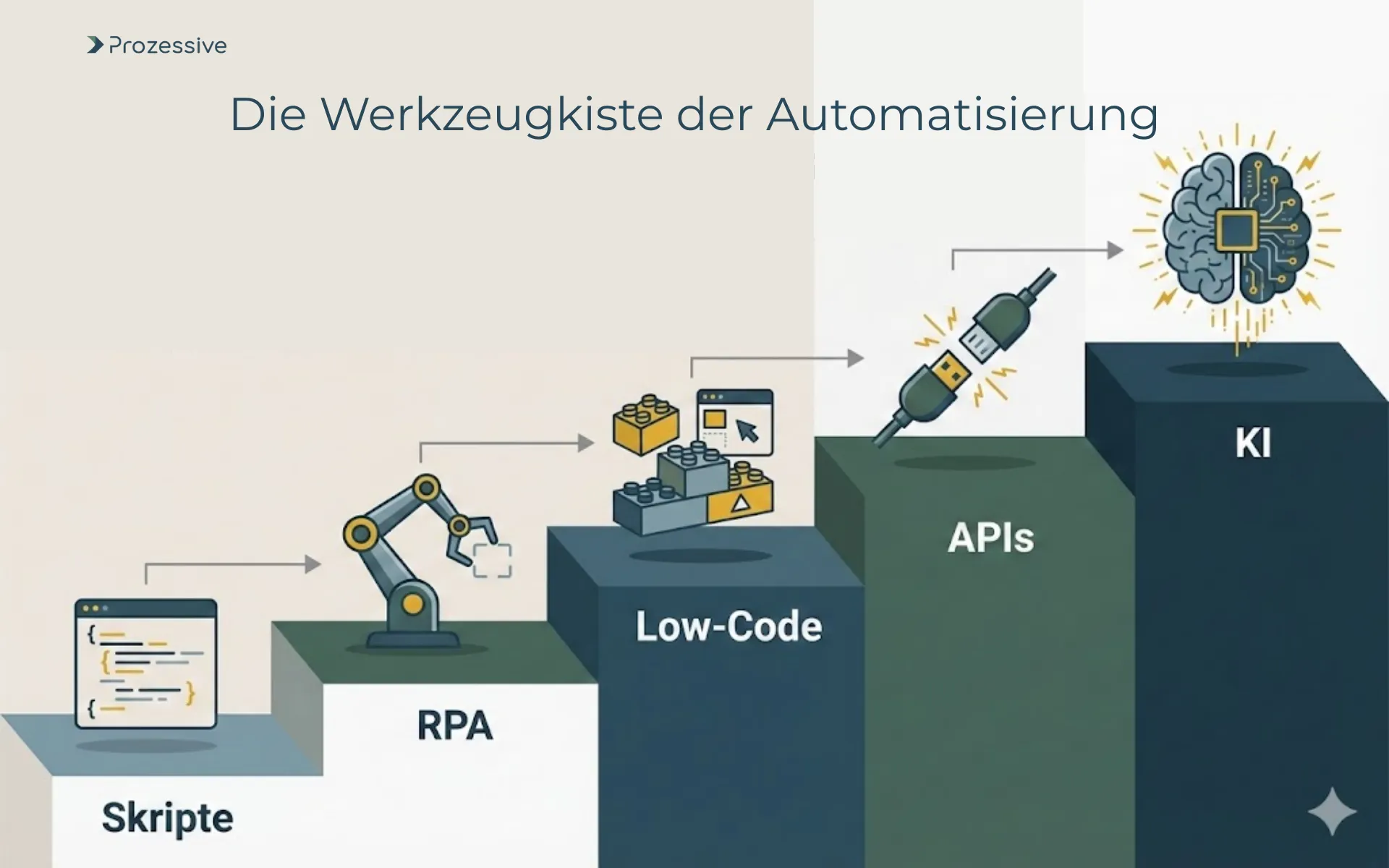

Lösungsansätze im Überblick: von Prozessanalyse bis Automatisierung

Der Weg aus der Routine beginnt nicht beim Tool, sondern bei der Prozessarbeit. Zuerst wird geklärt, was häufig passiert, wo Wartezeiten entstehen und welche Varianten es gibt. Danach folgt die Standardisierung, damit ein stabiler Zielzustand entsteht. Erst dann lohnt sich die Wahl des technischen Mittels. Zur Umsetzung stehen mehrere Ansätze bereit, vom kleinen Skript bis zur Plattformintegration. Die Wahl orientiert sich an Volumen, Regelgrad, Datenqualität und Risiken.

| Ansatz | typische Use Cases | Implementierungsgeschwindigkeit | Wartbarkeit | Anforderungen/Abhängigkeiten |

|---|---|---|---|---|

| Skripte | Dateiumbenennung, Formatkonvertierung, kleine Exporte | Schnell bei klaren Regeln | Mittel, abhängig von Pflege | Zugriff auf Quellen, klare Pfade |

| Robotic Process Automation | UI-basierte Eingaben, Legacy-Software ohne Schnittstelle | Mittel bis schnell | Mittel, Stabilität abhängig von UI | Stabile Oberflächen, definierte Ausnahmen |

| Low-Code/No-Code | Formulare, Freigaben, einfache Workflows | Schnell für Standardfälle | Gut bei Governance | Plattform, Rollen, Schulung |

| APIs und iPaaS | Systemkopplung, Events, Datenabgleich | Mittel | Hoch bei sauberen Verträgen | Schnittstellen, Sicherheitskonzept |

| Künstliche Intelligenz | Beleglese, Klassifikation, unstrukturierte Daten | Mittel | Abhängig von Daten und Drift | Trainingsdaten, Feedback-Loops |

| Individuelle Entwicklung | Kernprozesse, Differenzierung | Langfristig | Hoch bei sauberer Architektur | Produktivbetrieb, Versionierung |

Der Überblick zeigt: Es gibt keinen Königsweg, sondern eine passende Kombination. Wichtig ist, klein zu starten, Risiken zu begrenzen und Lerneffekte mitzunehmen. Ein stabiles Fundament aus Standardisierung und Governance erhöht die Erfolgswahrscheinlichkeit. So entsteht eine belastbare Roadmap statt Tool-Sammlung.

So starten Sie schnell

Ein schneller Einstieg braucht Klarheit. Ziel ist ein messbarer Pilot, der Kapazität freisetzt und Vertrauen schafft. Starten Sie dort, wo Volumen und Regelgrad hoch sind und Fehlerfolgen spürbar.

Binden Sie den Fachbereich eng ein, dokumentieren Sie nur, was für die Umsetzung nötig ist, und planen Sie früh die Betriebsphase. So wird Fortschritt sichtbar, ohne neue Komplexität zu erzeugen.

- 30 Tage:

- Top-3-Pilotkandidaten identifizieren (Volumen, Regelgrad, Fehlerfolgen), grobe IST-Skizze, Technikpfad vordefinieren.

- Business Case quantifizieren (Zeit, Fehler, Durchlaufzeit), Erfolgskriterien und Messpunkte festlegen.

- Minimal-invasiven Pilot entwerfen, Datenqualität prüfen, Ausnahmen definieren und abfedern.

- 60 Tage:

- Lösung bauen, mit dem Fachbereich testen, Freigabeprozess klären, Go-live-Checkliste finalisieren.

- Soft-Launch im begrenzten Umfang, aktives Monitoring und schnelles Bugfixing sicherstellen.

- Erste Optimierungsschleife, Dokumentation und Schritt-für-Schritt-Anleitung für Anwender erstellen.

- 90 Tage:

- Ergebnisse gegen Erfolgskriterien prüfen, Lerneffekte dokumentieren, Entscheidung zur Skalierung treffen.

- Nächste zwei Prozesse aus der Pipeline priorisieren und nach gleichem Muster umsetzen.

Geschwindigkeit entsteht, wenn Sie den Umfang klein halten, Risiken aktiv steuern und die Messpunkte vor dem Start festlegen.

Dieser Fahrplan minimiert Reibung und baut Vertrauen auf. Er ist bewusst pragmatisch gehalten und erlaubt frühe Korrekturen. So entstehen zügig spürbare Effekte, ohne sich langfristig festzulegen. Das erleichtert Budgetgespräche und stärkt die Akzeptanz im Team.

Umsetzungstiefe: Analyse, Automatisieren, Befähigen, Betrieb und Optimierung

Vier Bausteine tragen die Umsetzung: Erstens Analyse und Strategie: Prozesse aufnehmen, Varianten klären, Zielbild und Leitplanken definieren. Zweitens Automatisieren: passende Methode wählen, sauber schneiden, auf Ausnahmen achten. Drittens Befähigen: Wissen dokumentieren, Schulungen bereitstellen, Rollen klären. Viertens Betrieb und Optimierung: Monitoring, Incident-Handling und regelmäßige Verbesserungszyklen. Diese Struktur verhindert, dass neue Abhängigkeiten entstehen.

Wichtig ist eine disziplinierte Standardisierung vor der Technikentscheidung. Ebenso zentral sind klare Verantwortlichkeiten und ein Eskalationspfad für Ausnahmen. Ein pragmatisches Sicherheits- und Berechtigungskonzept schützt Daten und erleichtert Audits. Durch diese Ordnung bleibt die Lösung wartbar und anpassungsfähig, auch wenn Prozesse wachsen oder sich ändern.

Erfolg messen und skalieren: KPIs, Governance, Risiken adressieren

Wirkung wird sichtbar, wenn sie messbar ist. Geeignete Kennzahlen sind Durchlaufzeit, Fehlerquote, SLA-Einhaltung, Vollzeitäquivalente und Zufriedenheit der Beteiligten. Legen Sie Messpunkte vor dem Go-live fest und prüfen Sie die Datenqualität. Ergänzen Sie das operative Bild um qualitative Rückmeldungen aus dem Fachbereich. So entsteht ein realistischer Blick auf Nutzen, Risiken und Restaufwand.

Governance strukturiert die Skalierung. Dazu gehören Zugriffsrechte, Versionierung, geplanter Wartungszyklus und Monitoring. Für neue Vorhaben hilft ein einfacher Prozess mit Bewertungskriterien. Nutzen Sie etablierte Themen wie Prozessautomatisierung, Integration und den Umgang mit Medienbrüchen als wiederverwendbare Bausteine. Für tiefergehende Kennzahlen lohnt ein standardisiertes Reporting, etwa entlang einer schlanken KPI-Messung.

Fazit

Routine und Ineffizienz sind teure Mitarbeiter, die niemand eingestellt hat. Sie binden Zeit, erhöhen Fehlerquoten und schmälern Margen. Der Ausweg ist nüchtern: Prozesse verstehen, standardisieren und gezielt automatisieren - mit den passenden Mitteln wie APIs, Low-Code/No-Code oder Robotic Process Automation. Entscheidend ist ein kleiner, messbarer Start, der Vertrauen schafft und skalierbar ist.

Der nächste Schritt ist überschaubar: Identifizieren Sie einen Pilotprozess mit hohem Volumen und klaren Regeln und validieren Sie den ROI in 60 bis 90 Tagen. Halten Sie Risiken klein, messen Sie sauber und dokumentieren Sie Lerneffekte. So entsteht Schritt für Schritt eine belastbare Basis für Digitalisierung und Künstliche Intelligenz. Der Effekt: spürbare Entlastung, mehr Fokus und stabilere Margen.