· Andreas Schwarz · Fachartikel · 9 min read

Vom Sprachmodell zum KI-Agent: Wenn Antworten zu Aktionen werden

KI-Agenten verbinden Sprache mit Aktion. Der Artikel zeigt, wie aus LLM-Antworten belastbare Prozessautomatisierung wird.

Teaser

Viele Teams nutzen bereits Chatbots, doch echte Wirkung entsteht erst, wenn Antworten zu Aktionen werden. Dieser Artikel zeigt, wie Sie aus großen Sprachmodellen handlungsfähige KI-Agenten machen, die Aufgaben in Ihren Systemen auslösen, steuern und abschließen. Im Fokus stehen Prozessautomatisierung, Sicherheit und Messbarkeit. Sie erhalten klare Architekturhinweise, Governance-Bausteine und einen schlanken Einführungsfahrplan. So reduzieren Sie Risiken, behalten Kontrolle und erreichen Schritt für Schritt messbare Ergebnisse statt bloßer Dialoge.

Vom Sprachmodell zum KI-Agent: Wenn Antworten zu Aktionen werden

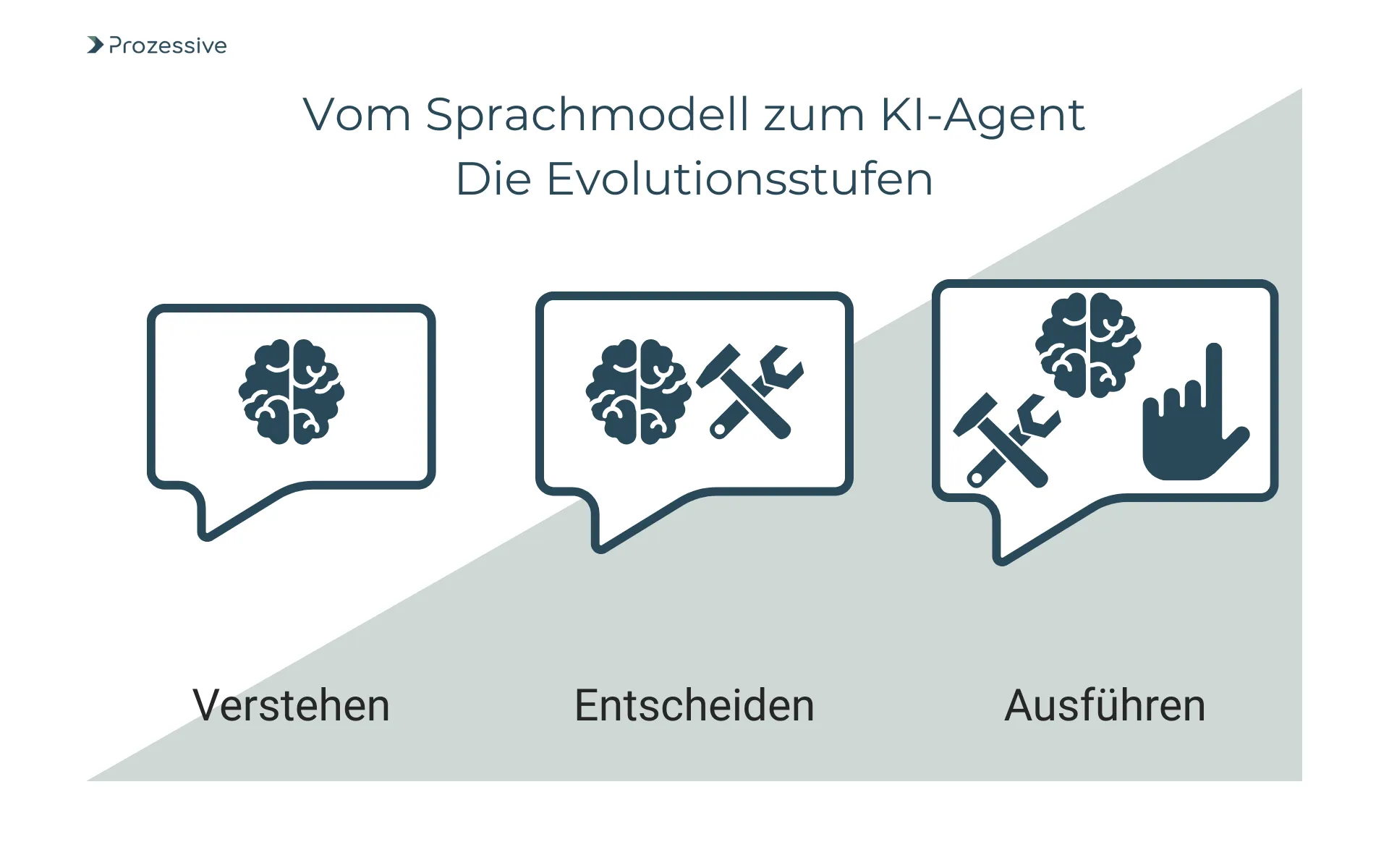

Viele Unternehmen in Deutschland haben mit LLM-Chatbots einen ersten Schritt in Richtung Künstliche Intelligenz gemacht. Die nächste Stufe ist jedoch anspruchsvoller: Systeme, die nicht nur sprechen, sondern handeln. Ein KI-Agent verbindet Verstehen, Entscheiden und Ausführen und damit Dialog und Prozessautomatisierung. Er greift auf Daten zu, ruft Funktionen in Ihren Anwendungen auf und schließt Vorgänge ab. Das schafft Entlastung und Tempo, verlangt jedoch neue Architektur-, Sicherheits- und Governance-Bausteine. Dieser Beitrag erläutert den Übergang vom Antwortsystem zum Agenten, priorisiert Risiken und zeigt, wie Sie pragmatisch starten, messen und skalieren.

Warum aus Antworten Aktionen werden

LLM-Chatbots beschleunigen das Finden von Informationen und das Erstellen von Texten. In operativen Abläufen reicht das selten aus. Die Wertschöpfung entsteht, wenn eine Antwort unmittelbar eine Aktion anstößt. Zum Beispiel das Anlegen eines Tickets, das Buchen eines Wareneingangs oder das Versenden einer Bestätigung. Prozessautomatisierung benötigt deshalb Agenten, die mit ERP-, CRM- oder IT-Systemen interagieren, Entscheidungen absichern und zuverlässig Workflows ausführen. Gerade in Organisationen mit etablierten Prozessen zählt nicht der Gesprächsfluss, sondern eine reproduzierbare Zielerreichung unter klaren Regeln.

Der Bedarf wächst, weil Arbeitslast und Regulatorik steigen, während Ressourcen begrenzt sind. Agenten können Routinevorgänge übernehmen, Durchlaufzeiten verkürzen und Fehler senken. Sie sind jedoch nur dann tragfähig, wenn sie sauber in Rollen- und Rechtekonzepte, Logging und Freigabeschleifen eingebettet sind. Damit verschiebt sich die Frage von “Kann das Modell die richtige Antwort formulieren?” hin zu “Kann der Agent eine korrekte, nachvollziehbare Aktion sicher ausführen?”. Genau hier setzt die folgende Architekturbetrachtung an.

Kernaussage: Antworten erzeugen Wissen, Agenten erzeugen Ergebnisse.

Von LLM zu KI-Agent - Architektur und Bausteine

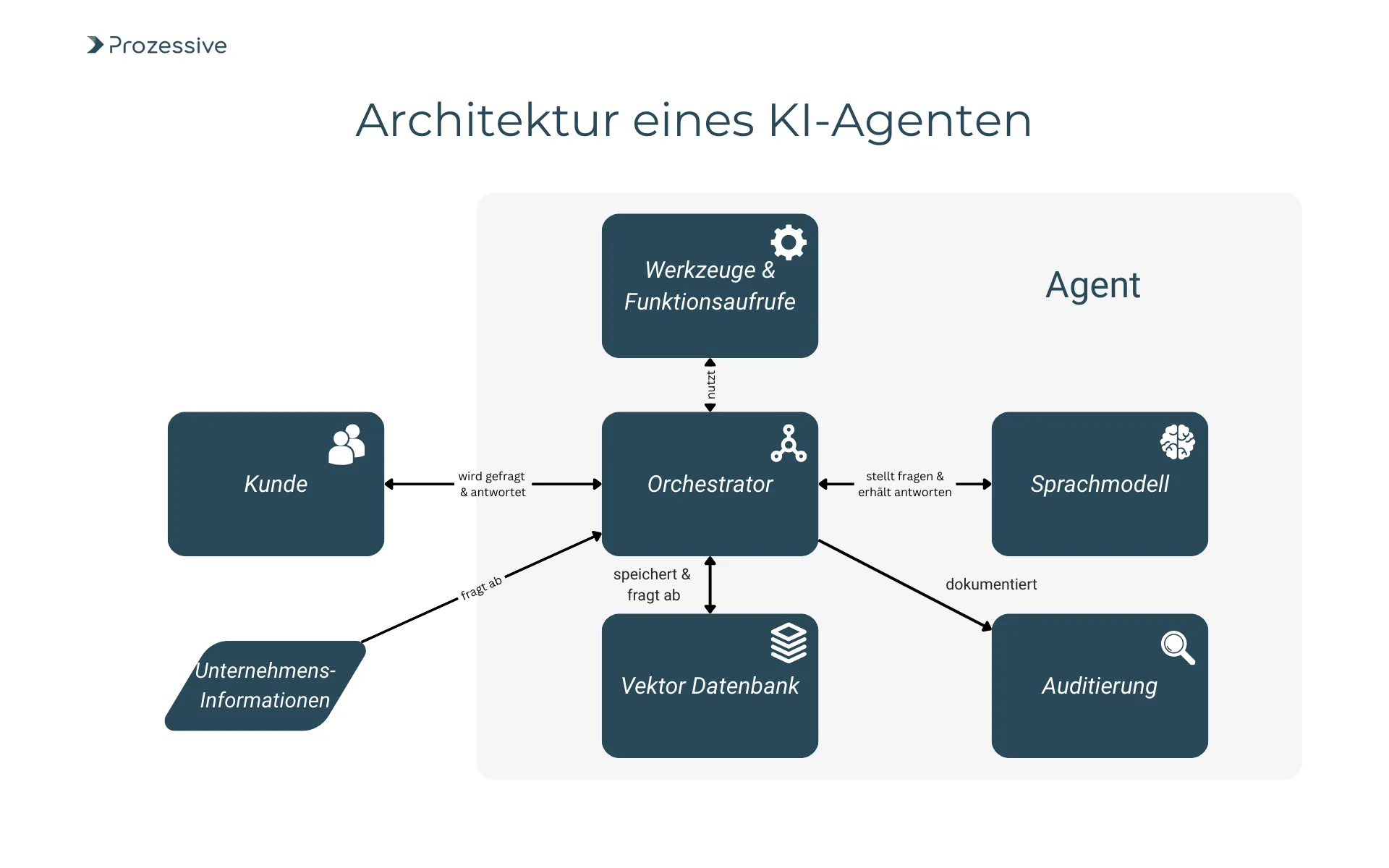

Ein KI-Agent ergänzt das Sprachmodell um Werkzeuge, Kontext, Speicher und Kontrolle. Technisch geschieht dies über Werkzeug- oder Funktionsaufrufe, bei dem das Modell strukturierte Befehle erzeugt, die konkrete Aktionen in Zielsystemen auslösen. Ein Orchestrator verwaltet Zustände, Fehlerbehandlung und Wiederholungen. RAG (Retrieval-Augmented Generation) liefert aktuelle, geprüfte Informationen aus Wissensquellen, bevor der Agent entscheidet. Memory speichert Sitzungs- und Fallkontext. Telemetrie erfasst jeden Schritt als Audit-Trail. Zusammen entsteht ein System, das planen, ausführen und nachsteuern kann und all dies unter klaren Leitplanken.

Für komplexere Aufgaben bewähren sich Plan-and-Execute-Muster. Das Modell zerlegt ein Ziel in Zwischenschritte, bewertet Zwischenergebnisse und entscheidet über den nächsten Schritt. Eine Orchestrierung kann diesen Plan begrenzen, priorisieren und bei Abweichungen eingreifen. In der Praxis werden Agenten oft in Domänen geschnitten, etwa “Rechnungsprüfung”, “Onboarding” oder “Incident-Response”. So lassen sich Berechtigungen gezielt steuern, Testabdeckung fokussieren und Risiken begrenzen. Die Integration erfolgt typischerweise über APIs, RPA-Adapter, Message-Queues oder systemeigene Workflow-Engines.

Wesentlich ist die Abgrenzung zum Chatbot: Ein Chatbot liefert Antworten im natürlichen Gespräch, ein Agent übernimmt Verantwortung für eine Aktion. Das verlangt stabile Schnittstellen, deterministische Validierungen und klare Abbruchkriterien. Auch die Benutzerführung ändert sich: Statt freiem Dialog dominieren gesteuerte Formulare, Button-Auswahlen und verbindliche Bestätigungen. So wird die Ausführung nachvollziehbar, testbar und sicher wiederholbar. Kurz: Der Agent ist ein Software-Komponente mit Sprachfähigkeiten, nicht ein Gesprächspartner mit beiläufigen Systemrechten.

Auslöser und Kontrollschleifen

Agenten benötigen definierte Trigger und Kontrollpunkte. Auslöser können Benutzereingaben, E-Mail-Ereignisse, Warteschlangen-Nachrichten, geplante Jobs oder Sensoren sein. Vor einer Aktion validiert der Agent Eingaben, zieht Kontext per RAG, prüft Berechtigungen und fordert bei Bedarf eine menschliche Freigabe an. Nach der Ausführung bestätigt er das Ergebnis, schreibt in die Audit-Dokumentation und stößt bei Fehlern Wiederholungen oder Rollback-Routinen an. Diese Schleifen machen aus generativer Intelligenz eine betriebssichere Automatisierung.

Beobachtbarkeit und Telemetrie

Ohne Transparenz ist kein Betrieb möglich. Jeder Agentenschritt sollte mit Metriken, Logs und Traces erfasst werden: Eingang, Entscheidung, Funktionsaufruf, Ergebnis, Dauer, Kosten, Fehlerklasse. Aggregiert ergeben diese Signale ein Bild über Latenzen, Erfolgsquoten und Problemquellen. Für regulierte Umgebungen sind unveränderliche Protokolle und prüffähige Audit-Pfade nötig. Beobachtbarkeit schützt nicht nur vor Ausfällen, sie schafft auch die Datengrundlage, um Agenten kontrolliert zu verbessern.

Einsatzfelder in der Prozessautomatisierung

Im IT-Service-Management priorisiert ein Agent eingehende Störungen, reichert sie mit Konfigurationsdaten an, schlägt Lösungen vor und führt genehmigte Änderungen automatisiert aus. Über APIs zu IT- und Monitoring-Systemen erstellt er Tickets, ändert Status und dokumentiert die Schritte.

In Finance kann ein Agent bei der Rechnungsprüfung Positionsdaten gegen Bestellungen im ERP abgleichen, Abweichungen klassifizieren und Freigaben auslösen. Der Nutzen entsteht durch kürzere Durchlaufzeiten, weniger Medienbrüche und konsistente Protokollierung im Kernsystem.

Im Einkauf unterstützt ein Agent die Bedarfsbündelung: Er konsolidiert Anforderungen aus E-Mails, prüft Verträge, wählt genehmigte Lieferanten und legt Bestellvorschläge an.

In der Logistik kann er Avis-Daten aus Nachrichtenformaten extrahieren, Slots buchen, Status an Partner melden und Engpässe eskalieren.

Im HR-Onboarding orchestriert er Aufgaben über IT, Facility und Payroll - vom Kontoantrag bis zur Hardware-Ausgabe - und hält Mitarbeitende über einen sicheren Chatkanal informiert. Entscheidend ist in allen Fällen die saubere Einbettung in Rollen, Freigaben und Berechtigungsebenen.

Im Kundenservice triagiert ein Agent Anfragen, prüft Gewährleistungsbedingungen, initiiert Ersatzlieferungen oder plant Vor-Ort-Termine. Mit RAG greift er auf aktuelle Produktinformationen zu und stellt konsistente Antworten sicher.

In der Fertigung liest er Maschinenereignisse, öffnet Instandhaltungsaufträge und bestellt Teile, wenn Schwellenwerte überschritten sind, stets geführt durch Sicherheitsgrenzen und genehmigte Playbooks. Diese Beispiele zeigen: Handlungsfähige Agenten sind kein separater Kanal, sondern werden Teil der Digitalisierung der Kernprozesse und wirken tief in der Automatisierung vorhandener Systeme.

Governance, Sicherheit und Transparenz in Deutschland/EU

Für den Betrieb in Deutschland sind DSGVO und sektorspezifische Vorgaben maßgeblich. Praktisch bedeutet das: Datensparsamkeit, eindeutige Zwecke, Rechtsgrundlagen, Speicherfristen und Betroffenenrechte. Technisch relevant sind Rollen- und Rechtekonzepte, Pseudonymisierung, Verschlüsselung und die Trennung produktiver und Trainingsdaten. Wichtig ist, dass Agenten nur die minimal nötigen Daten sehen und alle Aktionen lückenlos protokollieren. Betriebsräte sollten frühzeitig bei Mitarbeiterbezug eingebunden werden.

Der EU AI Act sieht - mit gestaffelter Anwendung - Anforderungen an Risiko-Management, Transparenz, Logging, Daten- und Modell-Governance vor. Viele Elemente decken sich mit guter Praxis: Dokumentierte Freigabeprozesse, nachvollziehbare Audit-Trails, Tests gegen definierte Qualitätsmetriken und Meldewege bei Vorfällen. Ergänzend braucht es Prompt-Governance: versionierte Prompts, Prüfungen auf Datenabfluss, redaktionelle Freigabe von Systemprompts und Schutz vor Prompt Injection. Eine klare Verantwortungsrolle je Agenten-Domäne sorgt dafür, dass Änderungen und Risiken aktiv geführt werden.

Wirkung messen - von Hypothese zu belastbaren KPIs

Vor dem Rollout steht eine messbare Hypothese. Beispiele: “Wir reduzieren die Durchlaufzeit der Rechnungsfreigabe” oder “Wir erhöhen die Erstlösungsquote im 1st Level”. Setzen Sie eine Baseline, definieren Sie Frühindikatoren (z. B. Wartezeiten, Queue-Längen) und Spätindikatoren (z. B. Fehlerquote, Nacharbeit). Ergänzen Sie Kosten- und Qualitätsmetriken: Agent-Laufzeit, API-Gebühren, Nacharbeit, SLA-Verstöße, Beschwerden, Compliance-Treffer. Wichtig ist eine saubere Zuordnung: Was hat der Agent getan? Was hat der Mensch getan? Ohne diese Trennung sind Interpretationen unscharf.

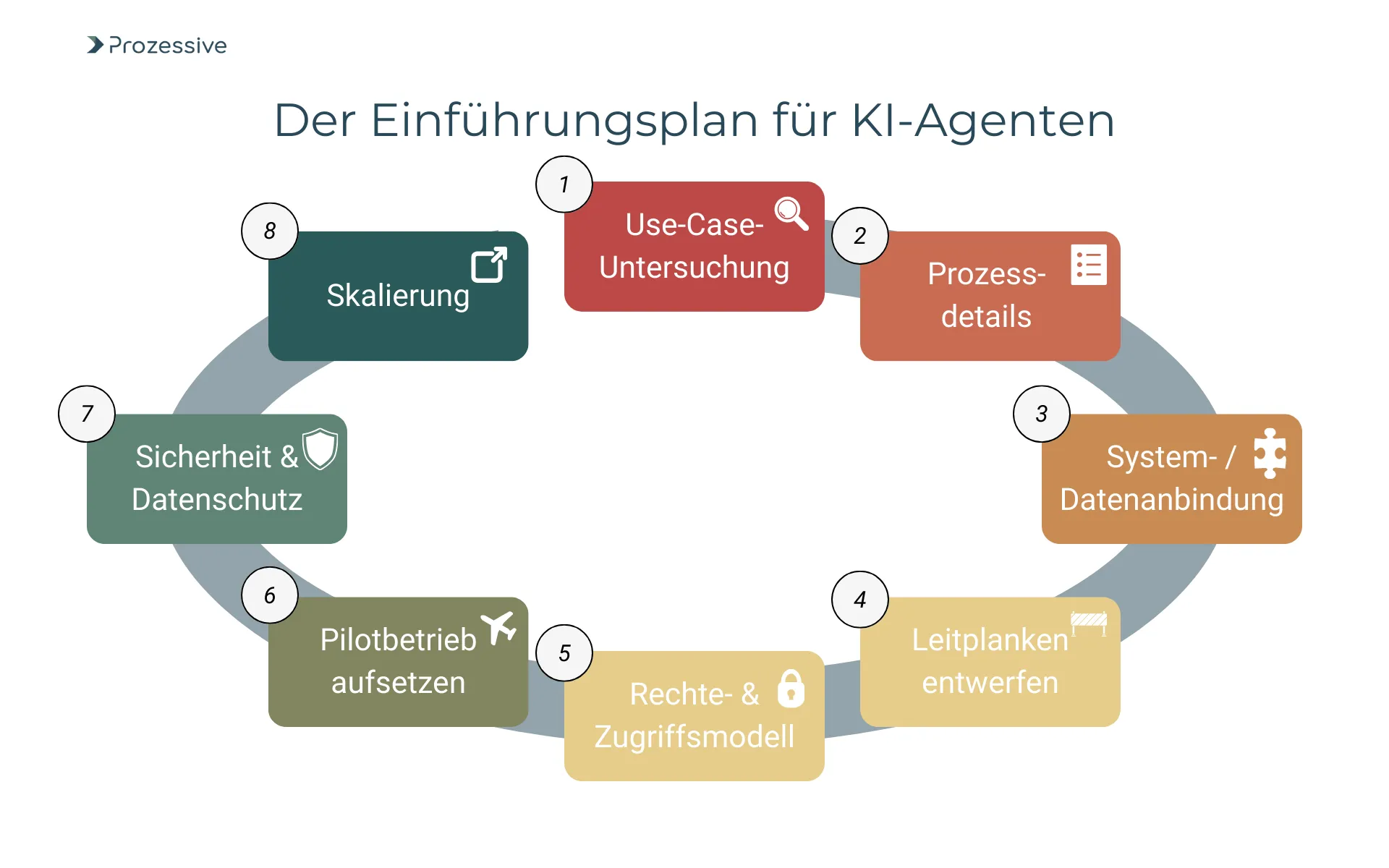

Einführungsfahrplan

Ein klarer Fahrplan reduziert Risiken und beschleunigt sichtbare Ergebnisse. Starten Sie klein, integrieren Sie früh die Sicherheit und testen Sie dort, wo Daten und Prozesse bereits strukturiert sind. Je präziser Ziel, Scope und Freigabemechanik, desto schneller lassen sich Lerneffekte in robuste Automatisierung überführen. Die folgenden Schritte sind in vielen Organisationen praxistauglich und skalieren von einem Pilot in die Breite, ohne Governance zu übergehen.

- Use-Case-Untersuchung mit Bewertung von Volumen, Standardisierbarkeit, Risiko und Schnittstellenreife.

- Detailprozess aufnehmen, Zielzustand definieren, Ausnahmen katalogisieren und Messgrößen festlegen.

- System- und Datenanbindung umsetzen, RAG-Quellen kuratieren, Funktionsaufrufe spezifizieren.

- Leitplanken entwerfen: Validierungen, Schema-Checks, Limits, menschliche Freigaben, Rollback-Regeln.

- Rechte- und Zugriffsmodell implementieren, Secrets-Management, Protokollierung und Auditierung aktivieren.

- Pilotbetrieb aufsetzen und klaren Abbruchkriterien definieren.

- Sicherheits- und Datenschutzprüfung (z. B. DPIA) durchführen, Betriebsrat informieren, Schulungen für betroffene Rollen durchführen.

- Skalierung nach erfolgreichem Pilot

Risiko- und Kontroll-Checkliste

Kontrollierbare Risiken erhöhen die Akzeptanz. Die folgende Checkliste bündelt praktische Kontrollen entlang Datenschutz, Sicherheit, Qualität und Betrieb. Sie eignet sich als Arbeitsgrundlage für Informationssicherheit, Fachbereiche und IT-Betrieb. Ziel ist, vor Produktivgang eindeutige Nachweise und im Betrieb kontinuierliche Belege zu haben. So bleibt der Agent steuerbar, prüffähig und anpassbar, ohne den Fluss der Automatisierung zu bremsen.

- Datenschutz by Design: Datenminimierung, Zweckbindung, Speicherfristen, Verschlüsselung, Pseudonymisierung; DPIA bei Personenbezug.

- Zugriffs- und Rollenmodell: Least Privilege, Vier-Augen-Prinzip bei risikoreichen Aktionen, Secrets-Management, Schlüsselrotation.

- Vollständige Protokollierung: Unveränderliche Auditierung, Logging, Ereignis-IDs, Aufbewahrung nach Richtlinie.

- Modell- und Prompt-Governance: Versionierung, Freigaben, Tests gegen Injection/Leakage, dokumentierte Änderungen.

- Qualitätsmetriken und Tests: Abnahmekriterien, Regressionstests, Szenario-Abdeckung, Referenzdaten, Grenzfallprüfung.

- Fail-Safes und Rollback: Abbruchkriterien, Wiederholungslogik.

- Incident- und Change-Management: Meldewege, Eskalationsstufen, Post-Mortems, Notfallpläne und regelmäßige Übungen.

- Laufende Überwachung: Kosten- und Latenzbudgets, Reports, anomale Muster, Zugriffsanomalien.

Grenzen, Annahmen und offene Punkte

Nicht jede Aufgabe eignet sich für Agenten. Freitext mit hohem Interpretationsspielraum, seltene Sonderfälle oder Prozesse ohne saubere Schnittstellen bleiben schwierig. Annahme: Latenzen unter realer Last sind oft höher als in Tests, weil externe APIs, RPA-Queues und Genehmigungen bremsen können. Ebenso gilt: On-Prem-Varianten sind kontrollierbar, benötigen jedoch mehr Infrastruktur- und Modellkompetenz. Cloud-Dienste erleichtern den Start, verlangen aber klare Daten- und Standortregeln. Wirtschaftlichkeit hängt stark von API-Kosten, Nutzungsprofil und Automatisierungsgrad ab.

Offen bleibt für viele Organisationen die Frage nach Verantwortlichkeit: Wer entscheidet bei widersprüchlichen Signalen? Hier helfen Human-in-the-Loop-Pragmatiken (menschliche Freigabeprozesse) mit Schwellenwerten.

Darüber hinaus erfordert Change-Management Zeit, denn Rollen verändern sich. Deshalb sind transparente Kommunikation, Schulungen und klare Erfolgskriterien genauso wichtig wie Technik.

Fazit

KI-Agenten erweitern Sprachmodelle von Antworten zu Aktionen. Sie verbinden Sprachverstehen mit Prozessautomatisierung, binden Systeme an, führen kontrolliert aus und protokollieren jeden Schritt. Wer Nutzen sehen will, startet mit einem engen Anwendungsbereich, klaren Leitplanken und einem belastbaren Messkonzept. Setzen Sie auf kleine, prüffähige Piloten, binden Sie Sicherheit und Fachbereiche früh ein und skalieren Sie entlang bewährter Muster. Beginnen Sie mit einem Prozess, der gut dokumentiert ist, eine hohe Fallzahl hat und sichere Schnittstellen bietet und machen Sie daraus Ihren ersten Agenten.